L’intelligence artificielle au service du bien commun. Qui pourrait s’opposer à une telle vision ? Certainement pas les travailleurs sociaux contraints par la charge administrative ou encore submergés par les dossiers qui s’accumulent et les accompagnements qui se complexifient. Pourtant, derrière les promesses séduisantes de CaseAI, le nouveau projet de Paul Duan et de son ONG Bayes Impact, se cachent des questions qu’il serait imprudent d’éluder. Et si on prenait le temps d’y réfléchir avant de s’enthousiasmer ?

L’intelligence artificielle au service du bien commun. Qui pourrait s’opposer à une telle vision ? Certainement pas les travailleurs sociaux contraints par la charge administrative ou encore submergés par les dossiers qui s’accumulent et les accompagnements qui se complexifient. Pourtant, derrière les promesses séduisantes de CaseAI, le nouveau projet de Paul Duan et de son ONG Bayes Impact, se cachent des questions qu’il serait imprudent d’éluder. Et si on prenait le temps d’y réfléchir avant de s’enthousiasmer ?

L’IA providence : un discours qui fait mouche

Dans son interview au Nouvel Obs, Paul Duan dresse un tableau convaincant : il s’agirait d’automatiser les tâches chronophages des travailleurs sociaux tout en fournissant la bonne information au bon moment. Ce logiciel devrait permettre aux professionnels de « se concentrer sur l’accompagnement humain ». Avec le soutien financier de Google.org (2 millions d’euros tout de même), CaseAI se positionne comme LA solution aux difficultés que rencontrent les professionnel(le)s de l’accompagnement.

Le projet présente trois pilotes actuellement en cours de développement : Il y a d’abord l’assistance aux écoutants d’e-Enfance pour les jeunes victimes de harcèlement. Vient ensuite l’aide aux conseillers de France Travail pour personnaliser les parcours des demandeurs d’emploi. Et puis il y a aussi un chatbot pour les patients transplantés hépatiques à l’hôpital Paul-Brousse. Si certaines applications ne sont pas directement conçues pour les travailleurs sociaux, tous ont une ambition louable avec un constat de départ indéniable : oui, les professionnels dont les travailleurs sociaux croulent sous la charge administrative. Oui, ils manquent de temps pour l’essentiel – la relation humaine.

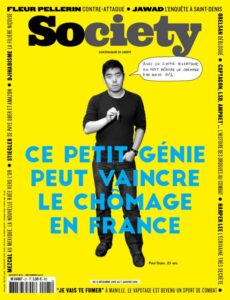

Mais voilà, on a déjà entendu ce discours. Certains se souviennent de Bob Emploi en 2016. Paul Duan promettait alors de faire baisser le chômage de 10 % grâce à son algorithme. Les résultats n’ont pas été à la hauteur des promesses, comme l’avaient rappelé plusieurs médias dont Libération. Non que le projet ait été un échec complet – 150 000 personnes accompagnées selon Bayes Impact – mais la réalité s’est avérée plus modeste que l’annonce tonitruante initiale.

Les données sensibles : le grand angle mort du discours

Ce qui me frappe dans la présentation de CaseAI, c’est le silence sur une question pourtant centrale : que deviennent les données personnelles des usagers ? Sur le site de CaseAI, il nous est expliqué que l’IA va « regrouper tous vos bénéficiaires au même endroit », « importer vos notes et fichiers », « transformer ces informations en recommandations concrètes ». Soit. Mais où sont stockées ces informations ? Qui y a accès ? Selon quelles modalités sont-elles sécurisées ?

Faut-il le rappeler ? Les travailleurs sociaux manipulent des données ultra-sensibles : situations familiales complexes, problématiques de santé mentale, violences intrafamiliales, addictions, parcours judiciaires… Autant d’informations qui relèvent du secret professionnel et qui, si elles tombaient entre de mauvaises mains, pourraient avoir de sérieuses conséquences pour les personnes accompagnées.

Le RGPD impose des règles strictes pour le traitement de ces données. Les travailleurs sociaux doivent s’assurer que les données saisies sont pertinentes, nécessaires, et protégées. La CNIL a d’ailleurs publié des recommandations spécifiques pour le secteur social. Alors, CaseAI est-il conforme à ces exigences ? Les données sont-elles hébergées en France ? Sont-elles chiffrées ? Qui peut y accéder au sein de Bayes Impact ou de Google.org, son principal financeur ?

L’open source comme gage de transparence ?

Sur son site, CaseAI se présente comme « Open source 🤍». C’est un point positif, indéniablement. L’open source permet en théorie à tout le monde d’auditer le code, de vérifier qu’il n’y a pas de failles de sécurité ou de collecte de données suspecte. Mais attention : open source ne signifie pas automatiquement sécurisé, ni conforme au RGPD. Et surtout, combien de structures du travail social ont les compétences techniques pour analyser ce code ?

De plus, l’IA générative utilisée par CaseAI s’appuie sur des modèles de langage (probablement développés par des géants du numérique). Ces modèles sont-ils entraînés sur les données recueillies par Case AI ? Les informations sensibles risquent-elles d’alimenter des bases d’apprentissage ? Autant de questions légitimes qui méritent des réponses claires avec des garanties.

Le risque des biais algorithmiques

Au-delà de la protection des données, nous savons désormais qu’une IA n’est jamais neutre (tout comme les humains) : elle reproduit les biais présents dans les données sur lesquelles elle a été entraînée. Dans le travail social, cela peut avoir des conséquences importantes.

Imaginons qu’un algorithme suggère des « plans d’action personnalisés » pour des demandeurs d’emploi. Si les données historiques montrent qu’une population donnée (par exemple, les jeunes issus de quartiers populaires ou les femmes de plus de 50 ans) a statistiquement moins de probabilités de retrouver un emploi rapidement, l’algorithme risque de les orienter vers des parcours moins ambitieux. Ce qui, au lieu de réduire les inégalités, pourrait alors les renforcer.

Que nous dit l’avis de la commission éthique du Haut Conseil du Travail Social ? Il explique que « l’utilisation d’algorithmes dans le travail social interroge les finalités des systèmes et nécessite une vigilance constante sur les biais ». On ne sait pas si Bayes Impact a mis en place des garde-fous et si des audits indépendants ont été prévus. C’est silence radio.

Et la relation humaine dans tout ça ?

Paul Duan affirme sans détour que CaseAI permettra aux travailleurs sociaux de « se concentrer sur l’essentiel : leurs bénéficiaires ». C’est séduisant sur le papier. Mais dans la réalité, n’y a-t-il pas un risque que l’outil devienne une nouvelle contrainte ? Que les professionnels soient jugés sur leur capacité à « alimenter » correctement le système plutôt que sur la qualité de leur accompagnement humain ? A regarder les écrans proposés, il faut surtout envisager une augmentation de la productivité avec un plus grand nombre de situations dans les portefeuilles des professionnel(le)s.

Nous avons déjà vu par le passé des logiciels métiers censés « faciliter » le travail des assistants sociaux se transformer en carcans administratifs. Certains prenaient beaucoup de temps pour remplir des cases, cocher des items, et justifier chaque décision avec des outils qui ne comprennent rien à la complexité des situations humaines. Et si CaseAI, malgré ses bonnes intentions, devenait un énième outil de contrôle et de normalisation des pratiques ? La question mérite d’être posée.

Des questions qui attendent des réponses

Je ne dis pas que CaseAI est une mauvaise idée. Je dis simplement qu’avant de déployer massivement un tel outil dans le secteur social, il faudrait répondre clairement à quelques questions fondamentales :

- Où et comment les données sont-elles stockées ? Quelles garanties juridiques avons-nous sur leur confidentialité et leur sécurité ?

- Qui a accès aux données ? Les équipes de Bayes Impact ? Google.org ? Des prestataires techniques ?

- Comment l’IA prend-elle ses décisions ? Quels sont les critères utilisés pour générer les « plans d’action personnalisés » ? Peut-on auditer ces choix ?

- Quels garde-fous contre les biais discriminatoires ? Comment s’assure-t-on que l’algorithme ne renforce pas les inégalités existantes ?

- Les usagers sont-ils informés et consentants ? Savent-ils que leurs données alimentent une IA ? Peuvent-ils refuser ?

- Quelle indépendance vis-à-vis de Google.org ? Le principal financeur a-t-il un droit de regard sur les données ou l’évolution de l’outil ?

Quelles pratiques professionnelles ?

Dans l’écran ci-dessous, y aurait-il quelque chose qui vous choque ?

Les commentaires sont-ils nécessaires ? Doit-on inscrire dans un dispositif piloté avec une IA par exemple que telle personne a subi une agression sexuelle et est enceinte ? Ces données à ma connaissance relèvent du secret professionnel et médical. Ici le risque est grand que ce type d’information soit à terme partagé.

Autre question cette fois-ci au sujet du travailleur social lui-même. N’allons nous pas vers un contrôle externe automatisé des actes posés par le professionnel avec des rappel le conduisant â être en quelque sorte piloté par la machine ? Il vous est indique si vous êtes en retard (selon quel critère ?) qui vous avez vu et qui vous n’avez pas vu. Cette logique de gestion de flux de personnes peut interroger tout professionnel.

Autre point : votre encadrement aura-t-il accès à ces écrans qui comptabilise le nombre d’heures d’accompagnement, le nombre de tâches assignées ou encore le nombre de bénéficiaires actifs ? Je sais dans la pratique ce que cela peut donner. La crainte de voir un pilotage par les chiffres pourait inciter certains professionnels à multiplier les actes afin de bien démontrer qu’ils sont indispensables et « travaillent bien » selon des critères quantitatifs.

Cette logique a des effets pervers. Elle conduit à vouloir agir de plus en plus vite. Or il faut accepter que certains temps de rencontres sont incompressibles, que certaines situations demandent une plus grande attention. les « managers » qui sont peut au fait de ces réalités pourraient être tentés de piloter lers équipes par les chiffres sans s’assurer de la qualité des actes posés.

Un outil reste un outil. Un marteau permet de planter des clous mais il peut être aussi une arme par destination pouvant blesser voir tuer celui qui en reçoit un coup sur la tête. La même logique se pose dans les outils censés nous aider. Iles peuvent devenir de simples outils de contrôle de l’activité par destination. Ce qui aggraverait immanquablement les conditions d’exercice du travail.

Tout cela devrait être discuté. Je préconise dans ce type de situation la mise en place d’instances de réflexion éthique permettant d’accompagner les usages de ces outils.

Gardons les pieds sur terre

Paul Duan mérite d’être salué pour son engagement en faveur du bien commun. Mais l’histoire récente nous enseigne la prudence. Bob Emploi n’a pas révolutionné le marché du travail. Les algorithmes de la CAF ont conduit à des injustices flagrantes. Les outils prétendument « neutres » reproduisent trop souvent les discriminations qu’ils étaient censés combattre.

Alors oui, discutons de CaseAI. Testons-le, évaluons-le, et assurons-nous d’en garder maîtrise et compréhension. Mais ne nous laissons pas aveugler par les promesses technologiques. Le travail social repose avant tout sur la relation humaine, la confiance, le secret professionnel. Tout outil qui viendrait fragiliser ces fondamentaux, aussi bien intentionné soit-il, mérite notre vigilance.

Et si, au lieu de chercher des solutions miracles dans l’IA, on commençait par donner aux travailleurs sociaux les moyens humains de faire correctement leur métier ? Plus de postes, moins de dossiers par professionnel, plus de temps pour accompagner. Parfois, les solutions les plus simples sont aussi les plus efficaces. Même si elles ne bénéficient pas du soutien de Google.

Source :

- Vous rêvez d’une IA au service du bien commun ? C’est la mission que poursuit Paul Duan…

- CHECKNEWS Que devient Paul Duan, le «génie» censé faire diminuer le chômage ? | Libération

- Avis de la commission éthique du Haut Conseil du Travail Social : Intelligence artificielle et travail social

- Site de CaseAI

photo : ![]() wayhomestudio freepik

wayhomestudio freepik

Une réponse

J’ai pu tester CASE AI, et si l’initiative est intéressante sur le papier, la réalité est bien différente. Plusieurs points m’ont profondément interrogé :

C’est pour moi, une IA qui ignore l’humain. Voir une intelligence artificielle proposer un plan d’action pour une famille m’a immédiatement posé question : qu’en est-il du lien humain, de l’écoute, de l’adaptation aux spécificités de chaque situation ? Le risque est de réduire le professionnel à un simple exécutant, alors que son expertise et sa sensibilité sont irremplaçables.

Aussi, les fonctionnalités sont déjà existantes et peu utiles. Le rappel automatique pour les familles non vues peut sembler pratique, mais des logiciels le font déjà. Quant à la synthèse des dossiers, elle est trop succincte, peu pertinente, et nécessite des corrections chronophages. Sans parler de l’impossibilité de corriger l’orthographe, une fonctionnalité basique qu’on attendrait d’un outil moderne.

L’argument principal de CASE AI est de gagner du temps pour se recentrer sur les usagers. Résultat ? J’ai perdu un temps fou à tout reprendre. La promesse d’être plus disponible n’a pas été tenue.

C’est donc pour moi, une IA conçue sans les professionnels de terrain. CASE AI semble avoir été développé par des experts en tech, mais sans comprendre les réalités du travail social. La finesse de notre métier, la complexité des situations, et nos besoins concrets ne sont pas pris en compte.